Obsidian插件使用记录

开端

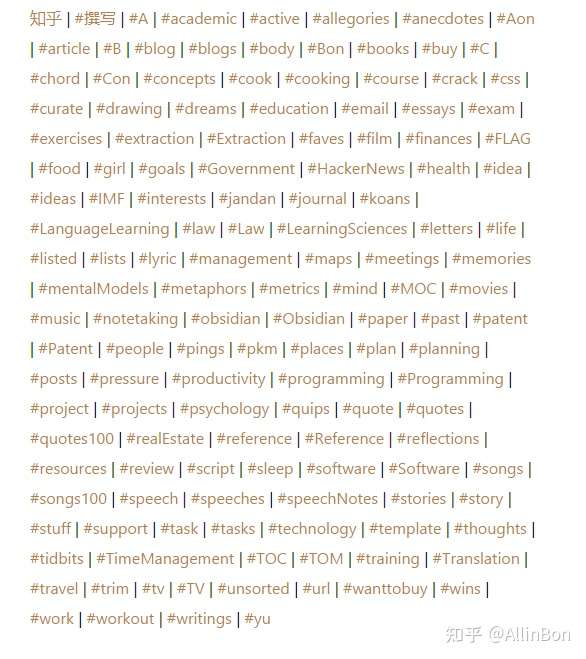

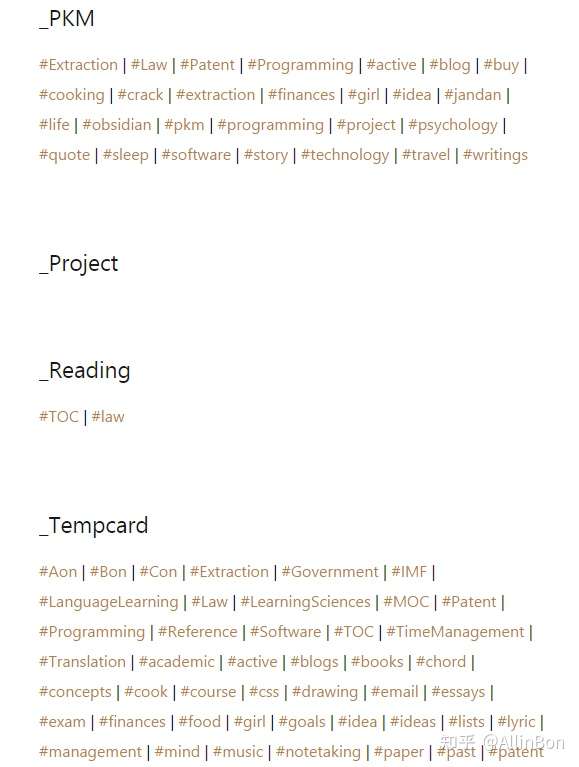

之前配置Obsidian的时候搜罗了很多各种各样的插件,不得不说Obsidian的插件生态真的好到起飞,这里列出自己使用或遇到过比较有用的插件,一方面是做一个记录方面以后查找,另一方面也回顾一下自己都安了哪些乱七八糟的插件(笑)。

插件

下面每个插件的标题均为Obsidian市场中的插件名,可以直接通过名称搜索到对应的插件。

Admonition

富文本扩展插件,能够在markdown中嵌入块样式的附加文字,从而与正文分开,可以用于填写增加一些评论、旁注、警告或追加醒目信息等功能。

平时用得不是很多,因为开始要自己配置admonition的名字,比较不开箱即用,可能还要探索一阵。

Advanced Table

表格功能增强插件,支持快速调整表格格式样式居中居右等功能,插件启动后会在左侧按钮列表中增加一个入口,点击后会在右侧打开控制panal使用。

实际上现在用表格比较少,所以暂时没用上。

Auto Link Title

增强URL功能插件,在粘贴URL到markdown中的时候自动切换成URL语法并且访问原地址获取网页标题填写到语句中,很方便。

Calendar

日历插件,能够在右侧日历面板(不确定是不是插件提供的)上为每个日子创建一个markdown文件,支持从模板创建并且展示一些信息到日历上快速索引。

是一个比较核心的插件,编辑模板以后可以做很多事情,比如说当每天的事件总结和起始事件,这样每天都等于有一个工作总结或者开端,不过有点尴尬就是这两个作用混在一起的话只有一个模板文件会难受一些,可能起始页这件事应该拆分到其它地方去。还有点麻烦的事情就是这个模板也不是开箱即用的,所以模板上需要自己花费很多精力去慢慢调整,如果能直接毛些别人的模板就好了hhh。

Checklist

Todo功能的扩展插件,功能是在右侧面板中提供一个Todo List面板,把各个markdown文件中的Todo事项全部列在一起,顺便还是彩色展示。

之前完全没意识到安装了这个插件,效果上Todo展示的效果非常直观,可以直接完成和开始任务,不过不确定这个完成时间能不能触发其它插件的时间记录,可能要测试一番,如果可以的话联动效果就非常好了。

Cycle Through Panes

让你可以使用ctrl + tab 的方式在多个文档间切换,ctrl + shift + tab是反向切换。

Dataview

可以说是Obsidian的杀手级插件之一了,赋予了Obsidian数据检索能力,能够把Markdown文件当作数据库来进行检索,支持多种SQL语法,并且也支持使用Javascript语法来编写查询逻辑,拥有极强的可玩性。

DataView本身还会为每个Markdown文件追加诸多元数据和追踪信息用于检索,从而提供更多可操作信息。

配合模板可以做到快速扫描Vault展示各种各样的信息,非常好用,强力推荐。

Day Planer

扩展插件,可以将Todo按时间线形式列出,因此能够用来安排日常规划,拥有一个面板来展示信息。

Editor Syntax Highlight

给markdown中代码块提供语法高亮功能。

Find Unlinked Files

查找vault中没有link或被link的文档,方便生成知识网络管理,触发方式是在command中使用find unlinked file。

暂时没有用过,可以用来偶尔查漏补缺一下以前拉下的笔记。

Incremental Writing

笔记管理插件,可以配置把笔记分成多个工作队列,从而完成多层流的笔记处理。

常见的可以把笔记放在未完成队列中这样每次可以补全笔记,更高深的用法可以是把笔记分成初次记录,后期文档化和标签化等多个队列,多个工作流一步步吸收归纳知识。

高级用法暂时没有使用过,目前暂时还是当作未完成队列在使用,因为这个模式是开箱即用的。

Kanban

将Markdown文件转化为看板,可以设置不同的工作条,但是具体的展示效果暂时没有测试过。

拿类似的独立产品Trello来说,Trello的进度条功能和拖动是非常好用的功能,如果没有这两个功能的话它对我的吸引力就没有那么大了,虽然做到了多合一但是牺牲了直观性。

Obsidian Linter

Markdown格式化工具,默认配置和Vscode类似都是在保存时自动进行格式化,有很多具体格式细节能够调整,并且支持自动插入一些YAML Tag,配合文档索引等功能非常方便。

让Markdown支持播放音频及视频,并且支持定位到指定的时间轴位置。

具体效果因为未使用过暂时未知,目前预想到的场景为看网课视频时做笔记能够快速索引到原文,或是在看视频作评论时能够使用。

扩展插件:Media Extended for Bilibili,大概是这样的名字,能够在插件市场中搜索到,顾名思义是为哔哩哔哩视频提供了引用支持。

Mind Map

将Markdown文档按标题顺序生成对应的脑图,某种程度上能够成为脑图绘制工具,或是在编写一份笔记时用来纵览思路,使用场景很多。

使用时通过command调出对应panel即可,可以放置在一旁作为速览。

使用上插件有时候会因为部分皮肤和主题之类的原因无法显示,兼容性相对比较差,使用时可能要和主题作一番取舍。

Natural Language Dates

通过@符号加today、tomorrow等关键词快速插入当前日期,属于快捷语法一类的插件,但是某些高级功能插件需要依赖这个插件功能运作,因此也属于必备插件之一。

Obsidian-Charts

在Markdown中插入好看的图表,使用方式可以通过Chart代码块创建或command呼叫图形化图表生成。

这个插件暂时没有使用过,不知道能不能配合dataview的数据检索进行操作,如果可以的话也将是一个非常好用的功能插件。

Obsidian Outliner

为markdown的list提供额外的快捷键控制,类似其它的markdown软件中快捷键,便于list的操控。

Pandoc Plugn

为Obsidian提供Pandoc支持,本身不带Pandoc组件需要自行安装,主要功能是提供word、html、latex、markdown等格式的导出,PDF导出功能已经由Obsidian官方支持并且兼容的功能更多,Pandoc主要是为其它场景使用。

安装后在command中调用即可。

Reminder

为markdown的Todo提供时间提醒功能,在Todo上标记时间即可触发,有一个独立面板按时间展示Todo,同时兼容Kanban插件和其它Task插件的语法,组合以后Obsidian在Todo追踪这一块功能就非常完整了。

目前暂时没有在使用,Todo功能虽然很全但是跨平台方面我还没有配置好,所以没有迁移过来,并且快速添加Todo会相对麻烦一些。

Self-hosted LiveSync

为Obsidian开启第三方兼容的实时同步功能,让Obsidian能够完全本地化运行,目前官方表示插件已经接近稳定但是可能还有数据损坏可能,此外它仅能用于同步而不是一个备份方案。

这个插件是刚发现不久的,并没有实际使用过,从功能目的上来说非常未来可期。

Sliding Panes

将Obsidian在多个文档间跳转的行为变成叠加多个panel,方便阅读时在多个文档间快速切换,非常方便。

Tasks

Obsidian的Todo管理增强插件,为Todo增加了日期时间、循环定时、完成时间记录等功能,让Obsidian可以作为一个比较完整的Tasks管理软件运作。

目前使用上还好,编辑时要配置Todo需要用command进行控制稍微有点麻烦,可能这里还有其它优化方式我没有发现,另外它对完成时间的标记能够被DataView识别,从而做到联动效果,这点非常方便,但是似乎DataView自身也能够对Todo的数据进行追踪,这部分可能需要再作尝试。

Templater

Obsidian的模板增强插件,支持众多插件语法和快速创建命令,支持按目录匹配模板等,此处功能介绍可以参考其官方的介绍,是Obsidian的核心扩展插件之一,很多管理技巧都可以通过它的模板功能实现。

Text Expand

Markdown语法扩展插件,可以在Markdown中对Vault内数据进行搜索并展示,只要预先设定搜索条件和规则即可。

这个插件之前安装后没有意识到它的存在,没有使用过,但是这种动态能力应该具有非常高的可玩性。

Vault Statistics

为Obsidian增加词数统计等功能,增强统计效果,算是基础插件之一,统计信息也是文档类编辑工具的基础能力了。

Workbench

这个插件在安装后也没有使用过,其功能描述为能够将当前UI中显示的信息(Todos、Block、段落等)生成链接插入到另一个已打开的Markdown文档之中,生成链接后在该文档里会直接显示成正文并且能够编辑和操作。

这个的作用似乎局限于已经打开的文档中?引用功能的话类似的插件还挺多的,不知道它的作用如何。

Youglsih Plugin

一个词典插件,能够快速给出某个词的定义和用例,甚至能够定位到相关网络视频(主要是油管)的发音用例,值得一提的是这个插件并不局限于英语。

词典功能很完善,有点奇怪的是我觉得Obsidian这个编辑器的功能有点差异,作为一个输入软件能够被查询的词可能用户不太能够直接输入到文档中,而能够输入到文档中的词通常也不需要进行查询,除非用户主动把未知的词汇粘贴进Obsidian来使用这个功能。

更理想的场景应该是放置到浏览器之类的输出软件因为那里用户能够接触到不了解的词汇从而进行词典查询,要在Obsidian里进行未知词汇查询就比较奇怪。这个插件也没有使用过。